損失函數(Loss function)、學習速率(Learning Rate)

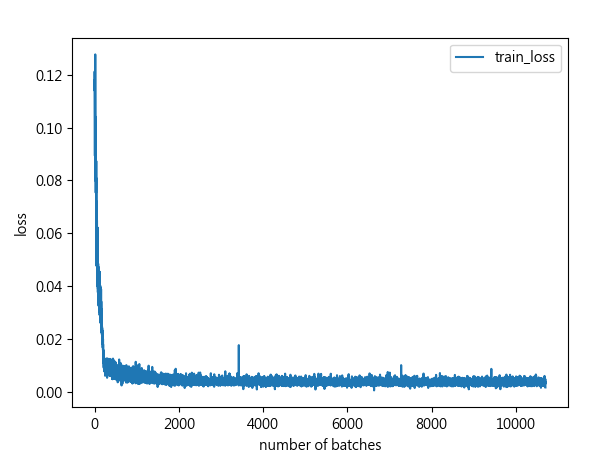

https://theprofessionalspoint.blogspot.com/2019/02/loss-functions-in-machine-learning-mae.html 損失函數(Loss function) 損失函數就代表「實際值跟預測值的殘差」 基本上分為兩個淺面向(分類、回歸),基本上都希望最小化損失函數。 在回歸問題中,我們通常希望模型很棒,預測出來東西可跟實際值趨近一樣。然而現實是不可能預測的值跟實際值會完全相同。預測出來的東西基本上跟實際值都一定有落差,在統計中針對此落差專業術語就稱作 「殘差」(residual) ,損失函數愈低愈好。 常見Loss function像是RMSE、MSE 和 MAE 等, 都是用於優化深度學習模型的最常用誤差函數。 假設一個模型採用訓練數據並預測下表中的數值。 target 是預測的正確答案,epoch 是訓練次數。 於以下表格中當第二次epoch時候,預測第 3 個值是一個異常值。 因為它預測到與目標的第 3 個值 7 有顯著偏差。 MSE、RMSE 和 MAE 的計算方法如下: 學習速率(Learning Rate) 在優化過程中,Learing Rate應該要逐步減小,越接近"山谷"時候,要邁開的"步伐:應該愈小。 通常用人工調節手法,可以先對Learning Rate設初始值,比方0.25,之後當跌代到一定程度比方第25個epoch時,再將Learning rate除以10,變成設為0.025。 或者自動調節,簡單有效的常見作法是,當驗證集準確率不再提高時,可將Learning rate減半或除以10,再繼續跌代。 不見得愈低(高)就愈好,剛剛好就會好,過猶不及。 會根據模型、訓練過程而有不同調節情況。 學習率設定0.5情況(步伐緩慢,但最終有成功到達目的地) 可以想像夜晚無燈光開山路的感覺,會十分緩慢步伐小十分謹慎。 學習率設定0.9情況(不夠謹慎,有喝醉酒亂走偏移情況,但最終也有成功到達目的地山頂。) 當學習率設定1情況(開始失敗,過猶不及,愈急愈容易失敗。) Ref: https://chih-sheng-huang821.medium.com/%E6%A9%9F%E5%99%A8%E5%AD%B8%E7%BF%92-%E5%9F%BA%E7%A4%8E...