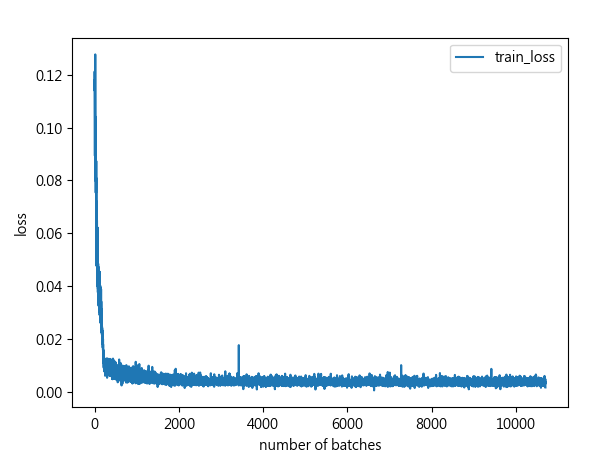

透過單方向LSTM進行短時間的交通流量預測_part2.建構資料集並進行訓練_RMSE,MAE,MAPE指標模型訓練效果可視化

程式碼 import numpy as np import time import math import torch import torch.utils.data as Data import matplotlib.pyplot as plt #引入sklearn現成的損失函數MSE(均方誤差),MAE(平均絕對誤差) #MSE(均方誤差):預測值減真實值後再平分取平均 #MAE(平均絕對誤差):預測值減真實值取絕對值後再取平均 from sklearn.metrics import mean_squared_error as mse,mean_absolute_error as mae from torch import nn #把第一階段資料讀取處理放在另一個.py檔案引入 from trafficflow_readdata import X_train, X_test, y_train, y_test device = torch . device( "cuda:0" if torch . cuda . is_available() else "cpu" ) print (device) #透過torch.utils.data建構模型訓練需要的訓練集物件 train_dataset = Data . TensorDataset(torch . Tensor(X_train),torch . Tensor(y_train)) #將測試集轉為張量 X_test = torch . Tensor(X_test) #用torch.utils.data建構數據產生器,按批次生成訓練數據 batch_size = 128 train_loader = Data . DataLoader(dataset = train_dataset, batch_size = batch_size, shuffle = True , #是否要隨機打亂數據 num_worker...