CDH Hadoop集群虛擬機本地配置搭建筆記_part8_透過Cloudera Manager(6.3)_安裝自訂服務YARN,Hive及Spark

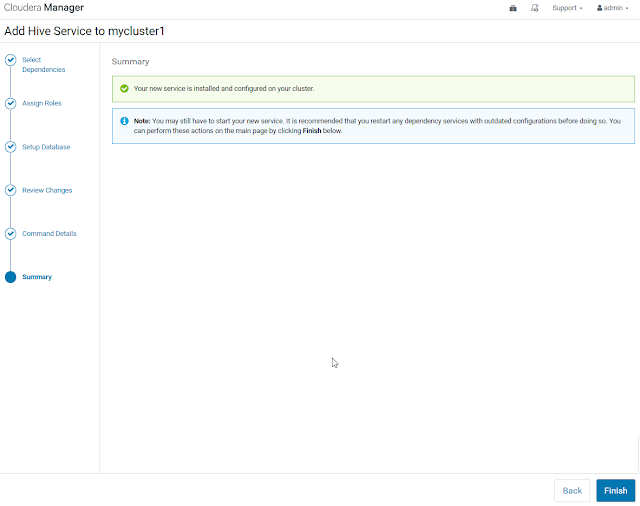

這邊要注意Spark和Hive這類服務安裝

都必須等到YARN安裝好才能接續安裝,因為是跑在YARN之上。

用默認分配即可

先將mysql連線用到的數據驅動jar上傳到以下路徑

/opt/cloudera/parcels/CDH-6.3.0-1.cdh6.3.0.p0.1279813/lib/hive/lib

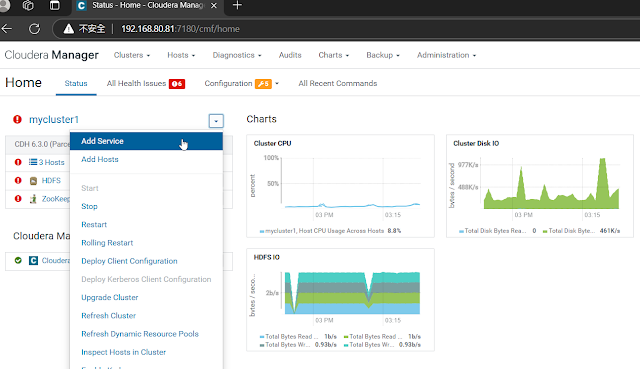

上傳好後再做Add Service

不過預設會看到CPU配置不足,這邊放著就好,因為剛好都配置一顆CPU。

硬體資源不足

VM跑會讓電腦十分卡頓....> ~ <||| God

若要確認目前自己電腦的CPU 跟 相關資訊可以打指令查看

WMIC CPU Get NumberOfCores

WMIC CPU Get DeviceID,NumberOfCores,NumberOfLogicalProcessors

安裝Spark

Apache Spark is an open source cluster computing system. This service runs Spark as an application on YARN.

當完成步驟後可以展開執行步驟

看到底層幫忙配置的

Spark User Dir

Spark History Log Dir

Spark Driver Log Dir

留言

張貼留言